Estudios

Pedagógicos, Nº 23, 1997, pp. 51-63

DOI: 10.4067/S0718-07051997000100005

ENSAYOS

USO DE LA DISTRIBUCION NORMAL EN LA EVALUACION DEL APRENDIZAJE

Use of the normal distribution in evaluating the learning process

Prof. Aquiles Fernández V.

Resumen

En los usos habituales

de la evaluación del aprendizaje, se suele considerar al modelo

normal de distribución de notas como ligado permanentemente al

tipo de evaluación conocido como “por norma” y aparte,

también de un modo definitivo, del tipo de evaluación conocido

como “por criterios”. Es frecuente pensar, además, que

la evaluación “por norma” corresponde a un tipo tradicional

de evaluación, mientras que la evaluación “por criterios”

representa el punto de vista actualizado. Sin embargo, el entender estos

asuntos de un modo tan simple es peligroso y puede llevar a los usuarios

que no son especialistas en evaluación a caer en gruesos errores.

En este trabajo intentamos adentrarnos en una mejor comprensión

del tema.

Abstract

Talking about subjects

related to assessing the learning process, it is frequent to refer to

the normal model of distribution of grades, linking it always with the

type of evaluation known as “by norm” and taking it aside in

a definite way from the evaluation known as “by criteria”. In

addition, it is usually maintained that the first evaluation method is

traditional, whereas the second is a modern one. However, such an oversimplification

is dangerous and may lead users who are not specialists in evaluation

to make serious mistakes.

In this article we attempt to achieve a better understanding of the topic.

1. INTRODUCCION

Es frecuente que, tratándose de temas relacionados con la evaluación del aprendizaje, se haga referencia al modelo normal de distribución de calificaciones asociándolo de un modo indisoluble al tipo de evaluación conocido como “por norma” y apartándolo, también de un modo tajante y definitivo, del tipo de evaluación conocido como “por criterios”. Se suele decir, también, que la evaluación “por norma” corresponde a un tipo tradicional de evaluación, mientras que la evaluación “por criterios” corresponde a un punto de vista actualizado. Más aún, suele afirmarse que no sería lógico que la distribución de las calificaciones pudiese corresponder a un modelo probabilístico tras un período dedicado a la enseñanza-aprendizaje; supuestamente, el azar no tendría cabida cuando ha existido un esfuerzo sistemático (no aleatorio) por mejorar los niveles del conocimiento. En cambio, sí podría tener cabida antes de que ese esfuerzo se hubiese realizado. Algunos libros dedicados a los temas generales de evaluación educacional (que, naturalmente, no profundizan en los fundamentos teóricos subyacentes en algunos de sus procedimientos) han contribuido a difundir los puntos de vista que hemos señalado.

Entendidas las cosas de esa manera, el modelo normal sólo sería aplicable en aquellos casos en que las calificaciones deben responder a la necesidad de ordenar a un determinado grupo de individuos “de mejor a peor”, para elegir de entre ellos a “los mejores”, sin que en esta elección exista referencia alguna a determinados objetivos de aprendizaje previamente señalados como metas que deberían estar cumplidas. No sería aplicable, en cambio, en aquellos otros casos en que las calificaciones deben reflejar el grado de concordancia entre el rendimiento de cada individuo y los objetivos previstos que éste debe alcanzar, independientemente de lo que ocurra con el resto de los individuos calificados.

Las puntualizaciones anteriores describen formas de posicionamiento que están bastante difundidas entre evaluadores del aprendizaje y que en una primera aproximación parecen razonables. Sin embargo, el entender estos asuntos de un modo tan simple es peligroso y puede llevar a los usuarios que no son especialistas en evaluación a caer en gruesos errores.

En este trabajo intentamos adentrarnos en una mejor comprensión del tema. Procuraremos aclarar, hasta donde las dificultades teóricas lo permitan, las zonas más oscuras de toda esta situación, comenzando por explicar cuál es el uso general del modelo probabilístico normal; veremos, a continuación, en qué circunstancias éste es aplicable a la evaluación educacional y, finalmente, examinaremos sus posibles relaciones con los tipos de evaluación “por criterios” y “por norma”.

2. USO DE LA DISTRIBUCION NORMAL

El Teorema Central del Límite (que hace referencia explícita al modelo normal) es, quizás, el resultado más importante de toda la teoría estadística desarrollada hasta ahora. Descubierto por De Moivre en 1733 y estudiado posteriormente por Laplace y Gauss, su forma definitiva sólo fue alcanzada a comienzos del presente siglo (Kendall 1980). Aunque su importancia teórica es muy grande, su interés radica también en la enorme cantidad de aplicaciones prácticas que su generalidad permite. Son, precisamente, estas aplicaciones las que han contribuido a “popularizar” el modelo normal hasta hacer que su conocimiento sea universal entre los usuarios de la estadística. Tanto es así que el término “normal” ha llegado a entenderse (equivocadamente, en el contexto de la teoría estadística) como sinónimo de “natural” o “acostumbrado”. Es cierto que éste puede ser el modelo habitual o adecuado en muchas circunstancias, pero también es cierto que no lo es, en muchas otras. Por ello, antes de querer aplicarlo o dejarlo de lado a priori, sería necesario verificar si las circunstancias de su correcta aplicación, en cada caso, están dadas o no lo están.

Enunciaremos este teorema del modo más simple que podamos, pero antes, para una mejor comprensión del mismo, daremos explicaciones breves de lo que es el modelo normal y del significado de algunos de los términos técnicos que (inevitablemente) tendremos que utilizar en el enunciado.

-

Una variable es una característica observable en cada uno de los elementos que conforman una población en estudio, cuya forma natural de expresión es un número (el término “variable” se suele usar con un significado más amplio, que abarca características no numéricas, tales como: estado civil, nacionalidad, sexo, etc.; sin embargo, en este contexto sólo usaremos el sentido más restrictivo que aquí se señala). Generalmente, el valor de una variable proviene de una medición hecha en el elemento observado. Por su parte, el término “aleatorio” significa “dependiente del azar”; sin embargo, en el contexto estadístico, también se entiende como “aleatorio” el efecto resultante de una o más variables no controladas, sean éstas conocidas o desconocidas, aun cuando nada tengan que ver con el azar. Lo esencial en el concepto de “aleatorio” es que, en un caso particular cualquiera, el número resultante de la observación sea impredecible. Así pues, una variable aleatoria es una característica que se expresa mediante un número cuyo valor, en un caso particular dado, es impredecible (aun cuando se sepa que dicho valor debe permanecer dentro de ciertos límites preestablecidos).

Por ejemplo, cuando tomamos una prueba escrita en un curso, no sabemos de antemano cuál podrá ser exactamente la nota promedio de esa prueba, aunque sí sabemos que tendrá que ser un número comprendido entre 1 y 7. Obviamente, el nivel de los conocimientos alcanzados por los alumnos durante su preparación para la prueba será determinante en los resultados y su conocimiento nos permitirá predecir “más o menos” lo que podría ocurrir con las notas, pero la certeza absoluta se nos escurrirá de las manos ante la influencia inevitable de otras variables que podrían escapar a nuestro control, tales como: validez y confiabilidad del instrumento utilizado, elección de los ítemes específicos considerados y no considerados en él; estado circunstancial de: salud, capacidad de concentración, motivación particular de cada alumno, etc. Esa nota promedio es, pues, una variable aleatoria; también lo son las notas particulares de cada uno de los alumnos.

Si quisiéramos ir un poco más lejos, podríamos afirmar que el resultado de cualquier medición (de cualquier índole) que no se pueda lograr con absoluta exactitud (y esto ocurre en la mayoría de los casos), es una variable aleatoria.

-

Una distribución probabilística o modelo probabilístico es una proposición concreta y anticipada del comportamiento de una variable aleatoria, en términos de su posible distribución. En el ejemplo que hemos considerado, y suponiendo que nuestro curso tiene 40 alumnos, podríamos basarnos en nuestra experiencia docente y predecir una distribución de notas como la siguiente:

|

Mientras la tabla adyacente sea una predicción de lo que eventualmente podría ocurrir en el futuro y no una descripción de lo que ya ocurrió, ella constituye un modelo probabilístico para la variable aleatoria descrita. | ||||||||||||||||

|

Naturalmente, lo que efectivamente resulte una vez tomada la prueba podría

ser diferente de lo que indica el modelo anterior. De ser así,

y en la medida que esas diferencias sean importantes, ello significa que

nuestra predicción ha sido equivocada. Contrariamente a esto, un

buen modelo probabilístico se debe caracterizar por su capacidad

para predecir lo que se puede esperar que resulte “regularmente”

cada vez que ocurra el fenómeno que el modelo representa, con aproximación

suficiente para satisfacer cualquier finalidad práctica. Al decir

“regularmente” queremos significar que muy rara vez un modelo

probabilístico, por muy bueno que sea, describe exactamente lo

que ocurre en cada oportunidad particular en que el fenómeno sucede

(evidentemente, si una variable se comportara siempre de un modo predecible,

ella no sería aleatoria). Sin embargo, las discrepancias que se

den entre un buen modelo probabilístico y las realizaciones del

fenómeno que él representa, nunca deberían ser demasiado

grandes ni, menos aún, sistemáticas.

Es mediante el uso de buenos modelos probabilísticos que, por ejemplo,

un casino o una compañía de seguros pueden planificar con

suficiente aproximación sus ingresos y gastos a largo plazo aun

cuando, quizás, no puedan hacerlo día a día.

Con un modelo probabilístico como el que se muestra en la tabla

siguiente, que está referido al número de incendios en instalaciones

industriales que se producen semanalmente en una determinada ciudad, una

compañía de seguros podría planificar sus finanzas

a (por ejemplo) un año plazo. En este ejemplo, la variable aleatoria

es el número de incendios producidos en una semana. Esta variable

se ha denotado con la letra X.

|

Un modelo como este (suponiendo que sea el adecuado) permite saber

anticipadamente, por ejemplo, que en un año se producirán

aproximadamente 77 siniestros. O saber que en una semana “regular”

cabría esperar que ocurran uno o dos incendios de este tipo,

ya que el promedio semanal, calculado de la tabla anterior, es igual

a 1.48.

Informaciones como las anteriores u otras de igual valor práctico

que también son deducibles del mismo modelo probabilístico,

son perfectamente utilizables con fines de previsión y planificación,

dada su alta regularidad a largo plazo, aun cuando ellas no constituyan

verdades absolutas e irrevocables, menos aún tratándose

de lo que pueda ocurrir (o no ocurrir) en un caso particular dado.

Del mismo modo, el director de un establecimiento educacional (que

siempre planifica su trabajo y que usa buenos modelos probabilísticos

para tomar sus decisiones) puede saber anticipadamente, por ejemplo,

el número de alumnos que serán reprobados en cada una

de las asignaturas de los distintos niveles de estudio, aun cuando

no sepa exactamente qué alumnos serán ésos; también

sabrá el número de horas de clase perdidas por diferentes

motivos, la cantidad de alumnos que alcanzarán niveles de excelencia,

el gasto originado por el uso de gimnasios y laboratorios, etc.

-

El valor esperado de una variable aleatoria (que sigue un modelo probabilístico determinado) es el promedio que esta variable toma dentro del modelo. Por ejemplo, en el caso de los incendios, dijimos que el promedio es 1.48. Es decir, el valor esperado del número semanal de incendios es 1.48. En el ejemplo de la distribución de notas, se puede comprobar, haciendo los cálculos respectivos, que el valor esperado de las notas es 4.875. No hay que olvidar, sin embargo, que una vez que la prueba haya sido efectivamente tomada y evaluada, el promedio real de las notas casi seguramente será algo diferente del valor esperado del modelo.

Si la variable aleatoria se denota por X, entonces su valor esperado se denota por E(X). Puesto que la existencia de un modelo probabilístico es independiente y anterior a cualquier observación real de la variable (X) involucrada, se puede decir que E(X) es el promedio a priori de dicha variable, supuesto un gran número de observaciones.

-

Así como en un modelo dado es posible calcular el promedio (a priori) de la variable pertinente (x), también es posible calcular a priori, en relación con la misma variable, cualquier otro de los estadígrafos conocidos, tales como la mediana, la moda, la desviación estándar, etc. En particular, llamaremos varianza esperada a la varianza calculada a partir de la distribución dada por el modelo y la denotaremos por V(X). En los ejemplos dados es posible calcular que la varianza esperada de las notas es 1.397 y la varianza esperada del número semanal de incendios es 1.442. (Recordemos que la varianza se calcula como el cuadrado de la desviación estándar y que es una medida de la dispersión de los valores que toma la variable).

-

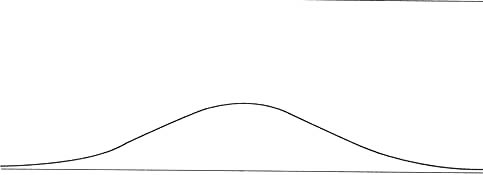

Ahora estamos en condiciones de recordar brevemente qué es el modelo normal. En la Ilustración Nº 1 podemos ver un dibujo que representa a nuestra conocida “campana”.

Su forma simétrica, con una parte central (donde se acumula

la mayoría de las observaciones posibles) y dos largas “colas”

en descenso perpetuo (allí se arrinconan, por uno y otro lado,

los casos más excepcionales), son algunos de sus rasgos más

notorios.

La curva, de forma tan característica, representa una distribución

de probabilidades, es decir, un modelo que permite explicar el comportamiento

de numerosas variables aleatorias. Este modelo tiene dos parámetros

(que son números fijos que determinan completamente al modelo):

uno de posición, que marca el lugar central de la curva y corresponde

al valor esperado (que puede ser cualquier número), y otro

de dispersión, que determina tanto el “ancho” como

el “alto” de la curva y corresponde a la varianza esperada

(que sólo puede tomar valores positivos). Diferentes combinaciones

de estos dos parámetros posibilitan la existencia de infinitas

curvas normales que difieren entre sí en cuanto a su posición,

a su forma, o a ambos aspectos (ver la Ilustración Nº

2). Aunque en todos los casos ambas colas de la curva son infinitamente

largas, la gran mayoría de las observaciones se encontrarán

alrededor del valor esperado, a una distancia no mayor que tres desviaciones

estándar. Si X es una variable aleatoria normal tal que E(X)

= 0 y v(x) = 1, entonces decimos que ella es una variable normal estándar.

Esta distribución es única (como cualquiera que tenga

fijos sus parámetros) y se puede encontrar tabulada en cualquier

libro de estadística.

Finalmente, diremos

que dos o más variables aleatorias son independientes si ninguna

de ellas puede explicar o ser explicada por una (o más) de

las otras, bajo ninguna circunstancia. Aunque en la práctica

ésta es una condición difícil de establecer fehacientemente,

lo usual, sin embargo, es suponer tal independencia cada vez que ello

parezca suficientemente aceptable por el sentido común. Por

ejemplo, si tomamos una vez más los ejemplos que hemos utilizado,

podemos suponer que el resultado de nuestra prueba es independiente

del número semanal de incendios que se declaren en la ciudad.

Nadie podría probar si esas variables son realmente independientes,

pero hasta que no sea hallada la relación entre ambas bien

podemos suponer que sí lo son.

Consideremos otro ejemplo: si lanzamos varias veces un dado bien equilibrado,

no nos será posible predecir el número que resulte en

cada lanzamiento, aun cuando conozcamos todos los números obtenidos

en lanzamientos anteriores. Si efectivamente es así, diremos

que estos resultados son independientes unos de otros y que constituyen,

por lo tanto, un conjunto de variables aleatorias independientes.

A partir de las explicaciones anteriores, estamos en condiciones de dar un enunciado del Teorema Central del Límite:

Teorema central del límite. Si se tiene un conjunto numeroso de variables aleatorias independientes, digamos: X1, X2, X3,… Xn, entonces la suma de todas ellas es una variable aleatoria, S, que sigue una distribución aproximadamente normal, cuyo valor esperado y cuya varianza son, respectivamente:

E(S) = E(X1)

+ E(X2) + E(X3) + ... + E(Xn)

V(S) = v(X1) + v(X2) + v(X3) + ... +

V(Xn)

La aproximación al modelo normal es tanto mejor cuanto más numeroso sea el conjunto de variables sumadas. El teorema se llama “del límite” porque si el número de variables sumadas fuese infinito, entonces el modelo resultante sería exactamente normal.

No obstante lo anterior, para cualquier finalidad práctica, la aproximación al modelo normal es bastante buena a partir, más o menos, de 40 sumandos (esto depende de cada caso particular). Por el contrario, dicha aproximación es tanto peor cuanto menor sea el número de variables que se sumen (excepto si esas variables sumadas son, cada una de ellas, normales). Por ejemplo, si lanzamos 5 dados (independientes) y sumamos los números obtenidos, la variable resultante no es una variable aleatoria normal. Pero si lanzamos 50 dados y sumamos los números obtenidos, la variable aleatoria resultante sí quedaría explicada por un modelo normal, con un valor esperado y una varianza esperada perfectamente calculables. Es decir, el comportamiento probabilístico de esta variable (la suma de los números obtenidos en 50 lanzamientos de un dado) sería suficientemente conocido y manejable por medio del modelo normal correspondiente.

El principal mérito y utilidad de este teorema radica en el hecho de que no hace ningún supuesto sobre las variables sumadas, aparte de que deban ser independientes y deban tener, cada una de ellas, un valor esperado y una varianza que sean sumables con todos los demás valores esperados y varianzas. Las variables involucradas pueden ser de las más diversas índoles: grandes o pequeñas, discretas o continuas, conocidas o desconocidas, parecidas entre sí o por completo diferentes, etc. Todo esto hace que el Teorema Central del Límite sea una herramienta sumamente poderosa, ya que “permite pronosticar el comportamiento de cualquier variable aleatoria cada vez que ésta pueda ser concebida como una suma de muchas otras variables aleatorias independientes”. Si se piensa en ello cuidadosamente, se verá que esta situación es más frecuente de lo que parece ser a primera vista. El ejemplo que sigue puede ayudarnos a comprender mejor los alcances de este famoso y poderoso teorema.

En una ciudad, los consumos de electricidad de los clientes de la Compañía Eléctrica local son variables aleatorias. Tenemos así muchas variables aleatorias cuyo comportamiento puede ser previsible, o no, para cada cliente en particular; en realidad, no estamos en condiciones de decir qué modelos podrían seguir estas variables (si es que tales modelos existen). Pero suponiendo que las cuentas de electricidad son muchas y que, además, todas ellas son independientes entre sí, podemos asegurar que el total de electricidad que la Compañía debe suministrar a sus clientes (o sea, la suma de todos los consumos individuales) es, indudablemente, una variable aleatoria que sigue un modelo normal.

3. APLICACIONES A LA EVALUACION EDUCACIONAL

Digamos, una vez más, que la afirmación fundamental contenida en el Teorema Central del Límite es que si sumamos muchas variables aleatorias independientes, el resultado de esa adición debe ser una variable aleatoria normal, sin importar cómo hayan podido originarse o qué signifiquen las diferentes variables sumadas. No obstante esta gran generalidad, que la teoría avala plenamente, lo usual en las aplicaciones (en especial las educacionales) es que la suma se obtenga a partir de una misma variable que es medida varias veces en forma independiente. Debe entenderse que es la suma (y no cada una de las variables sumadas) la única variable que el teorema identifica como normal.

Así, por ejemplo,

si en nuestro curso de 40 alumnos pudiésemos suponer que las notas

obtenidas en una prueba son independientes unas de otras, de modo tal

que la nota obtenida por un alumno no tenga relación alguna con

la nota obtenida por otro alumno cualquiera, entonces la suma de todas

esas notas será una variable aleatoria normal. Como consecuencia

de esto, el promedio de esas notas (que es la suma de ellas dividida por

40) será también una variable aleatoria normal.

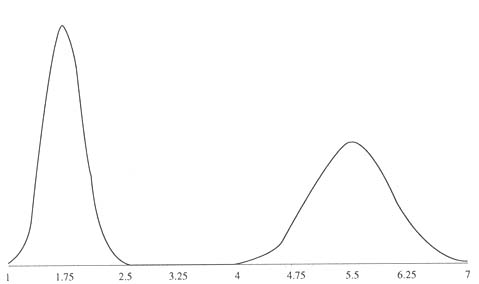

Notemos que en este ejemplo no estamos haciendo ninguna referencia a que

la prueba se pueda tomar a comienzos o a fines del año; no sabemos

si se trata de un pretest o se trata del examen final del curso. Los gráficos

de la Ilustración Nº 2 podrían corresponder a modelos

aptos para representar la distribución del promedio de notas en

un pretest y en un examen final, respectivamente. En el primer caso se

ha previsto (como ejemplo) un valor esperado igual a 1.75, con desviación

estándar esperada igual a 0.25; en el otro, un valor esperado igual

a 5.5, con desviación estándar esperada igual a 0.50. Nótese

que no se hace ninguna referencia a la forma de evaluación utilizada:

no sabemos si esas notas provendrán de interrogaciones escritas

u orales, si de pruebas de selección múltiple o de ensayo,

si de trabajos de investigación, disertaciones, pasos prácticos,

etc. Es posible suponer que se den simultáneamente cualesquiera

de esas alternativas, y también suponer que esas notas corresponden

a evaluaciones “por criterios”, sin que nada de ello pueda anular

el hecho de que éstas son distribuciones normales.

En el ejemplo que hemos dado nos referimos al promedio de notas en un

curso del que hemos supuesto dos premisas: que el curso es numeroso (de

40 alumnos) y que las (40) notas son todas independientes entre sí.

Esas son las condiciones, establecidas en el Teorema Central del Límite,

que nos aseguran que ese promedio debe ser una variable aleatoria normal,

sea cual sea la forma de obtención de cada una de las notas en

particular y sea cual sea el destino o interpretación que esas

notas tengan.

Veamos ahora otro ejemplo. Consideremos como variable aleatoria la (única) nota que un solo alumno puede obtener en una prueba determinada. Supongamos que ésta es una prueba de selección múltiple, en la que el alumno suma puntaje a su favor por cada respuesta correcta y disminuye puntaje por cada error. Una vez más pensemos en dos premisas: que el número de preguntas de la prueba es bastante grande (por ejemplo, 60) y que el acierto o fracaso en cualquiera de las preguntas no influye en el acierto o fracaso en cualquier otra. A partir de esas premisas, que son las del Teorema Central del Límite, debemos concluir que el puntaje final acumulado por el alumno en la prueba (y, en consecuencia, su nota final) debe ser una variable aleatoria normal. Y nuevamente podemos observar que es irrelevante si esa nota corresponde, o no, a criterios de logro preestablecidos y también es irrelevante que la nota se use para seleccionar personas, o para eliminarlas, o para cualquier otra finalidad.

4. EL MODELO NORMAL Y LA EVALUACION POR CRITERIOS

De acuerdo con los ejemplos que hemos desarrollado, ya debería estar claro para el lector que el hecho de que evaluemos “por criterios”, es decir, fijando claramente los estándares de rendimiento preestablecidos para asignar las notas correspondientes, no es en absoluto un motivo para descartar de antemano la posibilidad de que tales notas, o sus promedios, puedan tener una distribución normal. Más aún, si se dan exactamente las condiciones que establece el Teorema Central del Límite, tales variables serán inevitablemente normales.

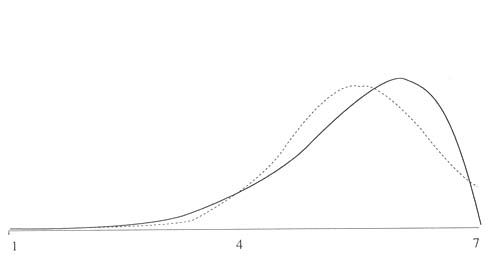

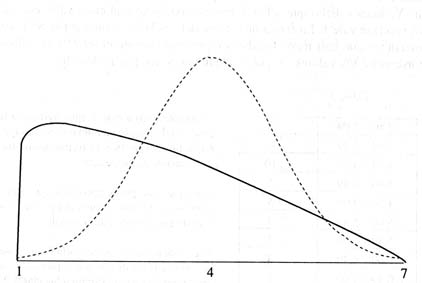

No obstante lo anterior, también debemos tener claro que el Teorema Central del Límite sólo nos provee de un modelo aproximado para explicar el comportamiento de las variables que nos interesen (y esto es así tanto si evaluamos “por criterios” como si lo hacemos de otro modo). Es, pues, perfectamente posible concebir otros modelos, diferentes del normal, que también ofrezcan la posibilidad de darnos buenas descripciones (también aproximadas, como con cualquier modelo teórico) del comportamiento de nuestras variables. Ellos pueden ser usados alternativamente, sobre todo en aquellos casos en que las referidas condiciones del Teorema Central del Límite no se den o parezcan dudosas. En relación con este punto, se ha propuesto (Fernández 1987) un modelo probabilístico, llamado Modelo Edumétrico, especialmente concebido para ser aplicado a distribuciones de notas en un contexto de evaluaciones “por criterios”. A modo de ejemplo, en la Ilustración Nº 3 se puede ver una distribución edumétrica de notas cuyo valor esperado es 5.5 y cuya desviación estándar es 0.90 (en escala de 1 a 7). En línea de puntos más suaves se insinúa la distribución normal con igual valor esperado e igual desviación estándar. Obsérvese que una parte de la cola derecha de la curva normal queda fuera del cuadro, es decir, se sale del rango de las notas, lo que es ciertamente no deseable, ya que el modelo supone la existencia de notas allí donde no las puede haber.

En síntesis, diremos que cuando se evalúa “por criterios” la distribución de notas puede ser convenientemente explicada mediante un modelo normal o no serlo, dependiendo esto de que se den, o no, las condiciones del Teorema Central del Límite. Si no se dan estas condiciones, el modelo adecuado podría ser algún otro diferente del normal, por ejemplo el modelo edumétrico.

5. EL MODELO NORMAL Y LA EVALUACION POR NORMA

Como sabemos, la característica esencial de la evaluación por norma consiste en relativizar la escala de calificaciones, ajustándola convenientemente de acuerdo con los resultados obtenidos por un grupo (relativamente numeroso) de alumnos sometidos a una misma prueba. En este contexto no interesa tanto que los alumnos evaluados demuestren dominio de ciertos objetivos predeterminados, sino que interesa hacer una selección de los alumnos que, en relación con el grupo evaluado, demuestren ser los mejores.

Como es obvio, lo más simple para el propósito anterior es ordenar todos los puntajes obtenidos, de mayor a menor o viceversa, y hacer un corte en el lugar que convenga a los propósitos de la selección. Sin embargo, si queremos presentar los resultados como notas (por ejemplo, en escala de l a 7) y de modo tal que sólo los alumnos de rendimiento igual o superior al promedio del grupo tengan una nota igual o superior a la nota de aprobación (por ejemplo, 4.0), entonces el problema es algo más complicado.

Consideremos un ejemplo. Para llenar 8 vacantes en cierto trabajo, han rendido un examen escrito de suficiencia 52 postulantes. Supongamos que la prueba se ha diseñado para medir el porcentaje de logro de ciertos objetivos predeterminados (criterios) y que sus resultados se expresan en un puntaje comprendido entre 0 y 100 puntos. Los siguientes son los resultados, ya ordenados, obtenidos por los postulantes:

| 94, |

88, |

82, |

79, |

74, |

71, |

65, |

64, |

62, |

61, |

58, |

57, |

55, |

| 54, |

50, |

44, |

43, |

41, |

40, |

38, |

36, |

34, |

34, |

34, |

31, |

30, |

| 29, |

29, |

28, |

28, |

25, |

24, |

24, |

23, |

23, |

20, |

18, |

18, |

15, |

| 15, |

14, |

14, |

13, |

13, |

12, |

11, |

10, |

10, |

7, |

7, |

5, |

2 |

Está claro que los

postulantes seleccionados deben ser aquellos cuyos puntajes fueron: 94,

88, 82, 79, 74, 71, 65 y 64. Sin embargo, ¿qué notas les

corresponden?

El mecanismo usual para responder a la pregunta anterior comienza por

calcular el promedio y la desviación estándar de todos los

puntajes. En el presente caso esos estadígrafos son 35.7 y 23.2,

respectivamente. Ellos permiten estandarizar los puntajes, o sea, restar

el promedio a cada puntaje y luego dividir la diferencia obtenida, por

la desviación estándar. En este caso, a cada nota se le

deberá restar 35.7 y la diferencia deberá dividirse por

23.2. En el ejemplo, los puntajes estandarizados son:

| 2.51, 2.25, 2.00, 1.87, 1.65, 1.52,

1.26, 1.22, 1.13, 1.09, 0.96, 0.92, 0.83, 0.79, 0.62, 0.36, 0.32, 0.23, 0.19, 0.10, 0.01, -0.07, -0.07, -0.07, -0.20, -0.25, -0.29, -0.29, -0.33, -0.33, -0.46, -0.50, -0.50, -0.55, -0.55, -0.68, -0.76, -0.76, -0.89, -0.89, -0.94, -0.94, -0.98, -0.98, -1.02, -1.06, -1.11, -1.15, -1.24, -1.24, -1.32, -1.45 |

Una vez estandarizados los puntajes, éstos son convertidos a notas definitivas adecuándolos a la escala que se quiera utilizar. En nuestro caso, ello se logra simplemente sumando 4 puntos a cada puntaje estandarizado. Hecho eso, las notas finales resultan ser:

| 6.51 |

6.25 |

6.00 |

5.87 |

5.65 |

5.52 |

5.26 |

5.22 |

5.13 |

5.09 |

4.96, |

| 4.92 |

4.83 |

4.79 |

4.62 |

4.36 |

4.31 |

4.23 |

4.19 |

4.10 |

4.01 |

3.93 |

| 3.93 |

3.93 |

3.80 |

3.75 |

3.71 |

3.71 |

3.67 |

3.67 |

3.54 |

3.50 |

3.50 |

| 3.45 |

3.45 |

3.32 |

3.24 |

3.24 |

3.11 |

3.11 |

3.06 |

3.06 |

3.02 |

3.02 |

| 2.98 |

2.94 |

2.89 |

2.85 |

2.76 |

2.76 |

2.68 |

2.55 |

|

|

|

El promedio de estas notas es 4.0 y la varianza es 1.

Es un teorema de la teoría estadística que si la distribución de los puntajes originales es normal, entonces la distribución de los puntajes estandarizados debe ser una normal estándar. Ya hemos dicho que así se llama el modelo normal cuyo valor esperado vale 0 y cuya varianza vale 1. La forma de este modelo es la de la Ilustración Nº 1, en la que debe entenderse que casi todos los datos (aproximadamente el 99.74% de ellos) deben encontrarse entre los valores -3, por la izquierda, y +3, por la derecha.

Sin embargo, si la distribución original no es normal entonces la distribución de las notas estandarizadas y, en consecuencia, la distribución de las notas finales, no tienen por qué ser normales.

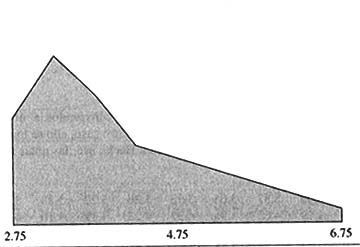

La Ilustración Nº 4, que representa gráficamente a la tabla anterior, expresa mejor lo dicho en relación con ella. Debe ponerse atención a los números puestos en su parte inferior, que representan a las tres principales marcas de clase.

|

|

En la tabla adyacente hemos agrupado las notas finales del ejemplo en nueve clases de igual tamaño, a fin de observar la forma aproximada de la destribución de estas notas. A simple vista puede apreciarse que esta distribución no es simétrica, como debiera serlo si se tratase de una distribución normal. Si esta distribución fuese normal, las clases 3 y 4, que son adyacentes al valor promedio, debieran ser de igual tamaño. También las clases 2 y 5, 1 y 6. Se ve que las notas altas están más repartidas. |

Comparemos el perfil anterior

con los que corresponden a una distribución normal (en línea

punteada) y a una distribución edumétrica (en línea

gruesa):

La distribución normal dibujada tiene el mismo promedio (4) y la

misma varianza (1) que el conjunto de notas finales. Por su parte, la

distribución edumétrica, que se caracteriza por tener un

único parámetro, llamado t (tiempo), en este caso se ha

tomado con el valor t = 2.2. Los valores paramétricos señalados,

tanto los del modelo normal como el del modelo edumétrico, son

los que mejor se ajustan a los datos del ejemplo.

A simple vista, ninguno

de los dos modelos parece representar muy bien al conjunto de datos. Sin

embargo, la prueba de bondad de ajuste de Kolmogorov-Smirnov (Canavos

1988) permite aceptar ambos modelos como válidos, con un nivel

de significación

a = 0.20. En lo que se refiere al conjunto original de datos (o sea los

puntajes antes de ser estandarizados), también resultan aceptables

los modelos normal y edumétrico respectivos.

En síntesis, queremos afirmar una vez más que no basta estandarizar los puntajes, o utilizarlos para discriminar a los mejores entre un grupo de alumnos sometidos a una misma prueba, para que el modelo normal sea automáticamente la mejor herramienta disponible. No depende de la estandarización el que las notas finales resulten ajustadas, o no, a un modelo normal. Todavía más, es posible que otros modelos sean tan válidos como el normal, o aun mejores, incluso cuando se esté evaluando por norma, como en el caso del ejemplo.

|

Ilustración

Nº 5 |

6. CONCLUSION

En este trabajo hemos intentado establecer dos ideas:

i) Existen dos formas de evaluación, que sirven a propósitos diferentes, denominadas “por criterios” y “por norma”, respectivamente. Ambas formas de evaluar son actuales y ambas son válidas en su respectivo contexto.

ii) Existen varios modelos probabilísticos que son aplicables a la evaluación del aprendizaje; entre ellos se cuenta el modelo normal. El correcto uso del modelo normal no está sujeto a la forma de evaluación a la que se le quiera aplicar; su aplicabilidad depende de otras premisas, independientes del tipo de evaluación que se use.

Av. J.P. Alessandri Nº

1701-J

Ñuñoa, Santiago, Chile

7. BIBLIOGRAFIA

AHUMADA, P. 1983. Principios y procedimientos de evaluación educacional. Ediciones Universitarias de Valparaíso, Chile.

CANAVOS, G.C. 1988. Probabilidad y estadística. Aplicaciones y métodos. Mc Graw-Hill, México.

FERNANDEZ V., A. 1987. “Medición y uso del tiempo en un contexto de aprendizaje para el dominio”, Estudios Pedagógicos 13: 15-27. Universidad Austral, Valdivia, Chile.

KENDALL & BUCKLAND. 1980. Diccionario de estadística. Ediciones Pirámide, Madrid.

MEZA, OLIVARES y PASCUAL. 1986. Evaluación educacional. Manual para educadores. Instituto de Servicio Educacional Chile.