Estudios Pedagógicos XXXVIII, Nº 2: 355-373, 2012

REVISIONES

En torno a la validez del Sistema de Medición de la Calidad de la Educación en Chile

About the validity of the Quality Measuring System of Education in Chile

Sobre a validade do Sistema de Medição da Qualidade da Educação no Chile

Iván Ortiz Cáceres

Universidad Alberto Hurtado. Telf.: 2-8897147. Correo electrónico: iortiz@cide.cl.

RESUMEN

El Sistema de Medición de la Calidad de la Educación (SIMCE) ha estado entregando resultados de aprendizaje por más de dos décadas, los cuales han tenido usos diversos por actores también diversos. La actual conciencia nacional acerca de las deficiencias de calidad y equidad del sistema escolar se basa en gran parte en esta información. Sin embargo, desde sus orígenes este sistema de información ha sido objeto de críticas y rechazo por parte de un amplio sector de docentes y académicos. El artículo revisa estas críticas y los principales usos de la información, en particular la elección de establecimiento educacional por los padres y apoderados, y el uso pedagógico de la misma por los docentes. Se sostiene que la validez de este sistema de medición se juega en gran medida en la utilidad de la información de resultados escolares para el trabajo pedagógico de los docentes.

Palabras clave: aprendizaje, calidad, equidad, sistema escolar.

ABSTRACT

Measurement System for Quality Education (SIMCE) has been delivering learning outcomes for more than two decades, having various uses by different actors. The current national awareness of the deficiencies of quality and equity of the school system is largely based on this information. However, since its inception this information system has been criticized and rejected by a large section of teachers and academics. This article examines these criticisms and the main uses of information, including the choice of schools by parents, and the pedagogical use of it by teachers. It is argued that the validity of this measurement system is played largely on the usefulness of school performance information for the educational work of teachers.

Key words: learning, quality, equity, school system.

RESUMO

O Sistema de Medição da Qualidade da Educação (SIMCE) tem fornecido, por mais de duas décadas, resultados da aprendizagem, os quais têm sido utilizados por diferentes razões e por diferentes atores. A atual consciência nacional acerca das deficiências de qualidade e equidade do sistema de ensino é, em maioria, baseada nessas informações. No entanto, desde a sua criação, este sistema de informação tem sido objeto de crítica e rechaço por grande parte dos professores e acadêmicos. Revisa-se tais críticas e as principais utilizações da informação, particularmente, a escolha do estabelecimento educacional pelos pais e procuradores e o uso pedagógico do mesmo por professores. Sustenta-se que a validade de este sistema de medição é jogada, em grande parte, na utilização da informação de resultados escolares para o trabalho pedagógico dos professores.

Palavras chave: aprendizagem, qualidade, equidade, sistema escolar.

1. INTRODUCCIÓN

El Sistema de Medición de la Calidad de la Educación (SIMCE) estaría cumpliendo 25 años de vida, según sugiere su sitio web institucional (www.simce.cl). Desde su creación, el lugar que ocupa la educación nacional en el debate público ha crecido enormemente, en parte gracias a la información que ha entregado. Sin embargo, es una institución que despierta mucha controversia en torno a sus usos. Los críticos del SIMCE son legión entre los profesores y profesoras, y entre los académicos de las facultades de educación, en cambio, los expertos involucrados en política educacional tienden a defenderlo.

El origen del actual SIMCE se remonta al año 1982, cuando se inicia un programa de evaluaciones del desempeño escolar en 4º y 8º año de enseñanza básica, conducido por la Universidad Católica de Chile (Programa de Evaluación del Rendimiento, PER). Si bien este programa no fue la primera experiencia de evaluación estandarizada del desempeño escolar en Chile –lo fue la Prueba Nacional aplicada a los 8º básicos desde 1968 a 1971- puede ser considerado el antecesor del Simce actual por la unidad de propósitos de ambos y por la continuidad de sus creadores. En efecto, el PER pretendía producir y comunicar resultados educativos para ayudar a los actores de la educación a tomar decisiones informadas; la novedad radicaba en que entre estos actores, los padres y apoderados figuraban como destinatarios cruciales. Se esperaba de ellos que usaran esa información para elegir un buen establecimiento para sus hijos, generando una demanda calificada, capaz de movilizar una oferta educativa de calidad por la presión competitiva. Tal propósito era, por cierto, complementario a la privatización de la educación y al financiamiento de la misma mediante el sistema de vouchers, controvertidas reformas de la dictadura.

Sin embargo, en los dos años que duró el PER el propósito anterior no se concretó. Eyzaguirre y Fontaine (1999) relatan que el Ministerio de Educación de la época se resistió a la publicación de los resultados con el argumento de que se estaba juzgando la labor del profesor sin tomar en cuenta las realidades socio-económicas del alumnado. Como puede apreciarse, la controversia en torno a este punto acompaña al SIMCE desde sus orígenes. Posteriormente, la Ley Orgánica Constitucional de Enseñanza de 1990 incluyó la obligación del Ministerio de Educación de publicar los resultados de los establecimientos en diarios de circulación nacional o regional, doblando así su resistencia. Pero hubo que esperar hasta 1995 para que se cumpliera la ley y los resultados escolares de los establecimientos fueran publicados en los diarios por primera vez.

El mismo equipo que creó el PER dio origen en 1988 al SIMCE actual, en la Universidad Católica, realizando la primera evaluación nacional del rendimiento escolar bajo tal sigla (Himmel, 1997). Ya en 1992, el SIMCE traspasado totalmente al Ministerio de Educación.

El carácter controversial del SIMCE se refiere a una diversidad de aspectos. El más emblemático es tal vez su uso mediático como rankings de establecimientos, en la medida en que hace visible y respalda una visión de la provisión del servicio educativo basada en el funcionamiento del mercado. No se trata solo de una crítica conceptual o ideológica de aquellos que prefieren que la educación no sea regulada por el mercado; se trata también de la estigmatización que sufren los profesores, directores y estudiantes de los establecimientos que obtienen bajos resultados, los que coinciden en gran medida con los establecimientos más pobres y los municipalizados.

Pero hay otros cuestionamientos. Uno de ellos se refiere al hecho de que el sistema mide solo una parte de los aprendizajes considerados fundamentales, lo que tendría como efecto no esperado una reducción de la noción de calidad educativa. Se trata de una conjetura, pues no hay ninguna evidencia de esto; al contrario, los padres y los profesores valoran una educación integral. En los hechos, es cierto que los aprendizajes que mide el SIMCE preocupan más que el resto a los directores, pero no se puede asegurar que esto estaría empobreciendo las oportunidades de aprendizaje que los establecimientos ofrecen a sus alumnos en las demás asignaturas o en los Objetivos Fundamentales Transversales. Es posible que esta crítica esconda una queja relacionada con el estatus diferencial de las distintas disciplinas, pero este es otro asunto y anterior al SIMCE.

Otro cuestionamiento, más grave, se refiere a los contenidos y preguntas de la prueba, los que no serían del todo relevantes, y modelarían negativamente la enseñanza. Esta crítica ha tenido mucho de verdad, pero tiene cada vez menos. Ha habido esfuerzos deliberados de la institución por mejorar las pruebas y progresos reales; si se comparara una prueba de mediados de los 90 con una actual, se encontrarían ítems de mejor calidad y más relevantes en la prueba actual. Pero es una línea de trabajo en la que aún hay mucho por hacer e investigar.1

Más allá de estos cuestionamientos, el SIMCE puede ser interrogado por la eficacia y legitimidad de sus usos de acuerdo a sus propósitos intencionales. En las próximas páginas revisaremos críticamente los dos principales usos de este sistema, es decir, hasta qué punto ha servido para orientar la demanda por buenas escuelas y hasta qué punto sus resultados han servido para que los docentes tomen mejores decisiones pedagógicas. Existe también un uso más genérico, para informar políticas globales de calidad y equidad educativas, pero los dos usos mencionados son los que justifican el carácter censal de la medición. En el fondo, se trata de la validez de este sistema. La validez dejó de ser un atributo intrínseco de la prueba, como hace algunas décadas, para convertirse en un atributo de las interpretaciones y usos de los datos que entrega. Valverde (2000) sostiene que actualmente se define la validez como el grado en que la evidencia empírica y la teoría dan sustento a las interpretaciones de los resultados de una medición; se refiere al ámbito del legítimo uso de esas interpretaciones, así como al grado en que el uso de la prueba no produce un impacto negativo no deseado en el sistema educativo.2

2. LA VISIÓN DE LOS EXPERTOS

En el año 2003 el Ministro de Educación convocó a una comisión de expertos para hacer un diagnóstico del SIMCE, especialmente de la información que éste proporcionaba y hacer recomendaciones para optimizar su impacto sobre la calidad de la educación. Por esa fecha, el descontento de muchos profesores, directores y académicos de la educación con el SIMCE era notorio. Lo que gatilló la decisión del Ministro fue la crítica según la cual el SIMCE no solo estigmatizaba a los establecimientos más pobres, sino que además la información que proporcionaba a los profesores y directores no era suficientemente útil como para fundamentar acciones pedagógicas específicas. Todo esto en el marco de una crítica generalizada de la calidad de la educación y del compromiso del Ministerio de mejorarla.

El diagnóstico que hizo la comisión de expertos reconoció aspectos positivos y negativos del SIMCE (Comisión para el Desarrollo y Uso del SIMCE, 2003). Entre los primeros, el hecho de que el sistema estaba instalado en la tradición del sistema educativo y gozaba de legitimidad y credibilidad; que había permitido centrar la atención de la opinión pública y de los docentes en los resultados de aprendizaje; que la calidad de sus instrumentos y metodologías de comparación de resultados había experimentado avances importantes; que era ampliamente utilizado como herramienta de apoyo a la formulación y evaluación de políticas educativas, y que pese a todo era utilizado por los docentes para analizar los logros de sus establecimientos.

Entre los aspectos negativos, la Comisión citó el hecho que los resultados reportados a los establecimientos no tenían mayor significado para orientar las prácticas pedagógicas, pues dejaban en la oscuridad qué saben o no saben los estudiantes y si los resultados alcanzados eran o no suficientes. Asimismo, reconoció que el SIMCE incentivaba prácticas no deseadas de exclusión y selección de alumnos como estrategia para mejorar los resultados, y de concentración de esfuerzos en las generaciones de estudiantes evaluados por este instrumento, en desmedro de las demás. También se mencionó que el manejo comunicacional de los resultados por los medios había distorsionado el sentido de la medición, pues presentaba rankings de establecimientos sin tomar en cuenta la influencia en ellos de los antecedentes familiares de los estudiantes. Otro aspecto negativo señalado fue el insuficiente conocimiento de los resultados Simce por parte de los padres y apoderados y el hecho de que no había datos concluyentes acerca de cómo y cuánto ellos usaban esta información.

Un aspecto interesante del diagnóstico de la Comisión se refiere al mal manejo comunicacional de los resultados: "significa una presión enorme para los gestores de política educacional, que en ocasiones los puede llevar a anunciar medidas impulsadas más por la fuerza de la opinión pública, que informados por un análisis profundo y sistemático" (41). No hay más detalles en el texto que expliciten el sentido de tal enunciado, pero podría interpretarse como que las autoridades educativas no deberían suprimir la publicación de los resultados SIMCE solo porque el manejo comunicacional de los mismos por los medios genera descontento en los usuarios.

La Comisión hizo una serie de recomendaciones frente a este diagnóstico, partiendo con un respaldo total al SIMCE en cuanto sistema encargado de entregar públicamente información válida y confiable sobre los resultados de aprendizaje de los alumnos de todos los establecimientos. De este modo, reafirmó la importancia de todos los usos que había tenido el SIMCE: con fines pedagógicos, de rendición de cuentas, de insumo para formulación y evaluación de políticas y de investigación. En general, la literatura admite que diferentes usos requieren diferentes instrumentos. Además, la Comisión prescribió entregar más y mejor información sobre estos resultados: aumentar la periodicidad de las mediciones en 4° básico, incluir nuevas áreas curriculares, reportar resultados en relación a estándares de desempeño, y canalizar directamente la entrega de información a todos los docentes y padres de cada establecimiento.

Todas estas recomendaciones se han venido cumpliendo desde entonces en diversos grados. Las mediciones en 4° básico se realizan todos los años a partir de 2005, en vez de cada tres; la periodicidad de las mediciones en 8° básico y 2° medio también aumentó, de cada tres a cada dos años. La inclusión de nuevas áreas curriculares se materializó en la medición del desempeño en escritura de los alumnos y alumnas de 4° básico en los dos últimos años. La entrega de resultados en relación a estándares de desempeño comenzó a hacerse efectiva en 2008 en 4° básico y se agregó 8° básico en la última medición, siendo tal vez la innovación informativa más importante y a la cual la comisión le había otorgado la primera prioridad de sus recomendaciones. Las modificaciones en los mecanismos de entrega de la información de logros escolares a los usuarios están viendo la luz este año, no sin controversia, con instrumentos que amplían la accesibilidad de los padres a los resultados comparados de los establecimientos.

3. ¿HA ORIENTADO EL SIMCE LA DEMANDA POR BUENAS ESCUELAS?

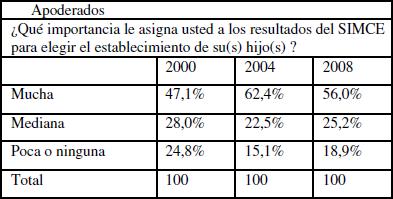

En su encuesta periódica, el Centro de Investigación y Desarrollo de la Educación (CIDE) ha preguntado a los padres y apoderados, en diferentes momentos, por la importancia asignada a los resultados del SIMCE para elegir el establecimiento educacional al cual enviar a sus hijos e hijas. El cuadro siguiente muestra los resultados para los años 2000, 2004 y 20008. En general, se puede decir que en comparación con el año 2000 en la actualidad hay más padres que le otorgan mucha importancia, superando la mitad de los encuestados. La misma encuesta ha revelado año tras año que más del 90% de los padres están de acuerdo con que los resultados SIMCE de los establecimientos sean públicos.

|

Cuadro 1 |

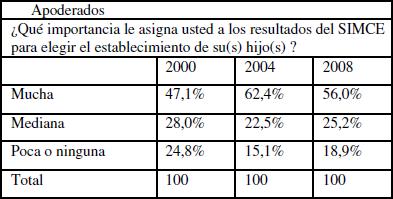

El Cuadro 1 siguiente muestra las diferencias por dependencia administrativa de los establecimientos en el año 2008,3 las cuales son similares en años anteriores. Curiosamente, los padres que menos importancia le otorgan a los resultados SIMCE para elegir un establecimiento para sus hijos pertenecen a colegios particulares pagados. Este dato puede interpretarse de la siguiente manera (Cuadro 2). Para estos padres, normalmente de nivel socioeconómico medio-alto y alto, la información diferencial que les aporta el SIMCE para elegir establecimiento sería superflua o redundante, puesto que su elección se circunscribe al estrato de los colegios particulares pagados, el cual tiene fama de tener buenos resultados SIMCE, y cuyas diferencias internas de puntaje serían menos valiosas que otros criterios de elección, como el costo del arancel, el proyecto educativo y los rasgos socio-culturales de los establecimientos.

|

Cuadro 2 |

Desde la perspectiva de los padres, la elección de establecimiento suele estar influida por varios criterios: costo financiero, distancia del hogar, clima y valores del establecimiento, nivel social del alumnado, calidad de las instalaciones, calidad de la enseñanza (según indicadores diversos), resultados escolares y otros. No todos pesan igual para todos. Aquellos padres que conceden poca o ninguna importancia a los resultados del SIMCE son una minoría. Por otro lado, aquellos que toman estos resultados como el criterio prioritario de elección son también una minoría, más reducida.

Los resultados de la encuesta CIDE son coherentes con los de un estudio reciente sobre condicionantes de la elección de colegios en Chile (Thieme y Rojas, 2009), realizado con una metodología más sofisticada. Este estudio encontró que si bien todos los padres valoran los factores académicos, especialmente el desempeño de los profesores, los de nivel socio-económico superior (quintil V) se caracterizan por considerar fuertemente aspectos de señalización social, como la dependencia del establecimiento y el nivel socio-económico del alumnado, en mayor medida que el puntaje SIMCE. En cambio, los padres de los quintiles I a IV valoran más la distancia al hogar y, de manera preponderante, la gratuidad o menor costo de la mensualidad, siendo este el atributo que condiciona su valoración del resto de los atributos deseables. Al comparar estos patrones de preferencia con los atributos de los establecimientos donde efectivamente estudian sus hijos, el estudio observa que todos los padres han actuado en conformidad con su patrón de preferencias, pero que los factores académicos (desempeño de los profesores y puntaje SIMCE) se encuentran en general por debajo de lo preferido. El estudio también reveló que la dependencia administrativa de los establecimientos actúa como imagen de marca.

Muchos padres han estado prefiriendo establecimientos con mejores resultados, cambiando a sus hijos de colegio en muchos casos. De acuerdo a Corvalán y Román (2010), entre el año 1998 y el 2008, el 60,2% de los establecimientos de bajos resultados SIMCE (230 puntos o menos) ha perdido más del 20% de su matrícula, en tanto que sólo el 16,5% la ha aumentado; el resto ha perdido menos del 20% de su matrícula o bien se ha mantenido estable. Los autores encontraron que año a año, un 15% aproximadamente de los alumnos de estos establecimientos se cambió a otro; la mayoría de ellos se cambió a un establecimiento con mejor puntaje, aunque solo el 1,4% lo hizo a un establecimiento de puntaje entre 260 y 300. Se podría decir que son consumidores racionales en el mercado de la educación.

La gran mayoría de padres que mantiene a sus hijos en escuelas con bajos logros parece no enterarse de que existen colegios mejores. No obstante, su comportamiento también es racional: no se cambian a establecimientos de mejores logros porque no pueden solventar los costos del cambio. Costos de todo tipo, pero principalmente económicos. En efecto, como ocurre en muchos mercados, el de la educación ofrece calidad en función del precio que debe pagar el consumidor, y los establecimientos con mejores resultados SIMCE tienden a cobrar un arancel más caro. Se podría objetar que aún entre los establecimientos gratuitos hay diferencias importantes de logros escolares. Pero, ¿qué cuenta como una diferencia importante de logro? A juzgar por el comportamiento de estos padres, cambiarse de un establecimiento de, por ejemplo, 230 puntos a otro mejor de 245, no vale la pena, sobre todo si hay otros costos asociados, como el desplazamiento diario. Por otra parte, los pocos colegios gratuitos o baratos con puntajes altos, suelen estar completos y seleccionar a los alumnos que ingresan.

El informe del Consejo aludido anteriormente, lamenta que los padres usen poco los resultados del SIMCE en la selección de establecimiento para los hijos; cita encuestas que muestran que solo para el 2% de ellos es un criterio prioritario, y propone estrategias para que todos reciban la información de resultados. A nuestro parecer, el Consejo tiene demasiadas expectativas acerca del uso de la información del SIMCE por los padres y apoderados. La evidencia indica que la elección de establecimiento tiene diversos condicionantes y que los resultados de aprendizaje tienen un lugar en la toma de decisión, aunque no prioritario, lo que es perfectamente razonable.

Cambiarse a un establecimiento de mejores resultados no es la única forma en que los usuarios podrían influir en la calidad de la educación. Hace algunas décadas el economista Albert Hirschman (1984) planteó tres opciones de los consumidores frente al descontento con los productos o servicios de una marca. Salida: abandonar la marca por otra. Voz: protestar para tratar de cambiar las cosas desde dentro. Y lealtad: quedarse de todos modos con la marca por gratitud, apego o identificación. Si la opción de salida es muy costosa para los apoderados de los establecimientos de bajos resultados, ¿por qué no usan la voz? Se ha investigado poco al respecto, aunque hay indicios de que estos padres no están tan descontentos con los establecimientos de sus hijos e hijas. El 61% de los apoderados de los establecimientos municipalizados califica como buena la enseñanza que imparte su establecimiento: el 35% la encuentra regular y solo el 4% la califica como mala (CIDE, 2008). Esto podría tener diversas explicaciones que no es el momento de analizar, pero está claro que muchos de estos padres no encuentran motivo para protestar, pese a que declaran conocer los resultados de aprendizaje del establecimiento de sus hijos.4 Tienen una conciencia de calidad intraducible a puntajes SIMCE . No sería de extrañar, por otra parte, que algunos padres hayan intentado protestar en sus establecimientos, sin ser escuchados o sin lograr nada. La opción de la voz supone que los consumidores tienen un poder real de influencia, el que se funda en la amenaza de salida. Vuelta a lo mismo: los padres de escasos recursos no tienen opción de salida. En respuesta a Hirshman (op cit.), Bajoit (1988) mostró que la gente puede quedarse en una institución pese al descontento con su calidad, pero no por lealtad. Cuando la voz no sirve porque no tiene peso o no es escuchada, y no existen posibilidades reales de salida, solo queda la apatía.

4. ¿HA MEJORADO EL USO PEDAGÓGICO DE LOS RESULTADOS SIMCE?

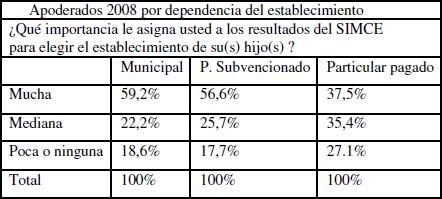

El uso pedagógico de los resultados SIMCE no ha sido tema de investigación en el país, cuestión que notó Himmel (1997) en los años 90 y que corroboramos hoy, al menos en los concursos de proyectos FONDECYT y FONIDE. Una aproximación a este objeto de estudio se encuentra, no obstante, en una saga de encuestas de opinión a actores educativos conducida por el Centro de Investigación y Desarrollo de la Educación (CIDE). En general, la importancia otorgada por los docentes a los resultados entregados por el SIMCE para realizar acciones de mejoramiento de los aprendizajes en los establecimientos, ha crecido con el paso del tiempo. De acuerdo a la VII Encuesta a Actores del sistema Educativo, realizada por el CIDE (2008) en el año 2000, la mitad de los profesores le daba poca o ninguna importancia al SIMCE para promover acciones de mejoramiento del aprendizaje, en cambio, en los últimos años, esa proporción ha disminuido a la cuarta parte, aproximadamente. Los directores le asignan más importancia al Simce que los profesores, pues frente a la misma pregunta sólo el 6% de ellos contestó "poca" o "ninguna" en 2008. Estos patrones de resultados son muy similares entre las tres dependencias administrativas de los establecimientos.

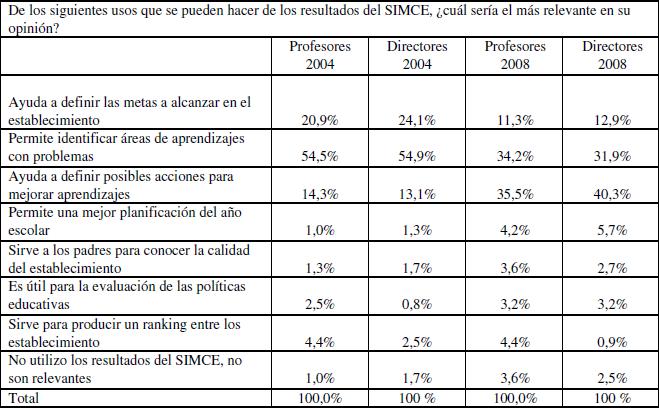

La pregunta del Cuadro 3 formulada a los docentes y directores no se hace cargo de cuáles son las "acciones de mejoramiento", ni distingue entre acciones del director y del docente. Pueden tener diversos grados de generalidad, como sustituir profesores, poner presión a los actores, aumentar las horas de las asignaturas medidas, o aumentar la cantidad de textos de lectura exigidos a los estudiantes, por ejemplo. El Cuadro 4 siguiente permite conocer algo más, pero sin detalles pedagógicos, cuáles son los usos más relevantes de la información aportada por el SIMCE.

|

Cuadro 3 |

|

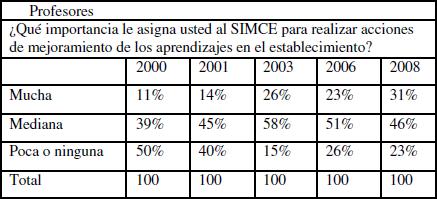

Cuadro 4 |

El Cuadro 4 muestra que: i) profesores y directores tienen opiniones muy parecidas, ii) el año 2004 los usos más relevantes eran la definición de metas y la identificación de áreas de aprendizaje con problemas, los cuales son de una gran generalidad; iii) en el año 2008 hay un aumento importante de las preferencias por "definir posibles acciones para mejorar aprendizajes"; iv) los resultados Simce no se usan para mejorar la planificación del año escolar. Es posible que los cambios entre el 2004 y el 2008 se deban a las innovaciones en la información reportada por el Simce a partir de 2007.

Pondremos ahora el foco del análisis en la apreciación que tienen los docentes de las novedades informativas que el SIMCE les hace llegar. La idea es que los docentes reciban resultados que vayan más allá del puntaje y tengan mayor significado y utilidad pedagógica, describiendo de qué son capaces los alumnos del sistema y de cada establecimiento, y cuántos han alcanzado o superado las expectativas que se establecen. En efecto, los docentes están recibiendo información de esta naturaleza, bajo la denominación niveles de logro, para Lectura, Escritura,5 Matemática y Comprensión del Medio Social Natural y Cultural de 4° básico; y para Lectura y Matemática de 8° básico. Se trata de una información cualitativa y cuantitativa a la vez, en la medida en que los niveles de logro (avanzado, intermedio e inicial) son descripciones de los desempeños que son capaces de hacer los estudiantes, y se acompañan del porcentaje de ellos que está en cada nivel. En principio, permite a los establecimientos fijar metas pedagógicas más específicas que si se cuenta solo con el puntaje bruto (por ejemplo 260) como información.

"Gracias a los Niveles

de Logro, una escuela no solo sabrá, por ejemplo, que su promedio

en Lenguaje y Comunicación es inferior al alcanzado por estudiantes

de escuelas con similares características socioeconómicas.

Además sabrá que, por ejemplo, la mayoría de sus

estudiantes de 4° Básico se ubica en el Nivel Inicial y que

un pequeño porcentaje de sus estudiantes alcanza el Nivel Avanzado.

Frente a esta información, docentes y directivos ya no solo podrán

contrastar sus esfuerzos en relación con los de otras escuelas,

sino que podrán hacerlo en función del nivel de aprendizaje

alcanzado por sus estudiantes. Para contribuir a que los estudiantes alcancen

más y mejores aprendizajes, las escuelas podrán, junto con

querer mejorar su puntaje promedio, plantearse la meta de lograr que un

menor porcentaje de alumnos y alumnas esté en el Nivel Inicial

y, al mismo tiempo, que un mayor porcentaje de estudiantes demuestre los

aprendizajes del Nivel Avanzado" (Ministerio de Educación, 2009:6). |

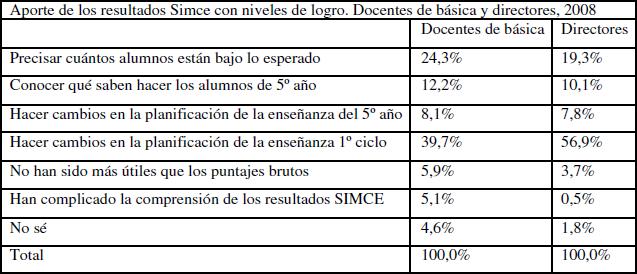

En su Encuesta 2008, el Centro de Investigación y Desarrollo de la Educación preguntó a los docentes y a los directores por el principal aporte de los resultados con niveles de logro, después de la segunda vez que los establecimientos habían recibido esta clase de información para 4° básico. Los resultados revelan que los docentes tienen una impresión positiva de la utilidad de los niveles de logro.

El cuadro 5 muestra que el principal aporte para los docentes6 y para los directores es que la nueva información ha permitido hacer cambios en la planificación de los aprendizajes del primer ciclo básico; en menor medida, también la planificación de 5° básico (es decir, el curso al que se refieren los resultados). Al contrastar estos datos con los anteriores referidos a la utilidad de los resultados SIMCE en general, encontramos que el aporte de los niveles de logro para la planificación es una novedad interesante.

|

Cuadro 5 |

El cuadro 5 revela, de paso, que los docentes y directivos preferirían, razonablemente, focalizar sus esfuerzos estratégicos en acciones que rendirían frutos en el corto plazo en vez del mediano y largo plazo. Si no, ¿por qué las preferencias se inclinan por hacer cambios en la planificación del primer ciclo en vez de hacerlo en el 5° año? La información proporcionada por los niveles de logro describe las fortalezas y debilidades de los estudiantes de 4° básico del año anterior, que ahora están en 5° año; sería de la mayor pertinencia hacer cambios en la planificación de los aprendizajes de estos alumnos y alumnas, una vez recibida la información cualitativa aportada por los niveles de logro. Pero los docentes y directivos se inclinan por hacer cambios en la planificación del primer ciclo, probablemente porque desean prepararse mejor para la prueba SIMCE de 4° básico que tendrá lugar ese mismo año.

Si bien se trata de indicios favorables, es necesario conocer con más precisión de qué manera la enseñanza se está beneficiando con esta manera de informar los resultados SIMCE; las preguntas de la encuesta sólo dejan ver aspectos muy generales. Por de pronto, la expresión "hacer cambios en la planificación de la enseñanza" no aclara si se refiere a la planificación general del año, o a la planificación clase a clase, las que refieren a dos niveles de concreción muy diferentes.

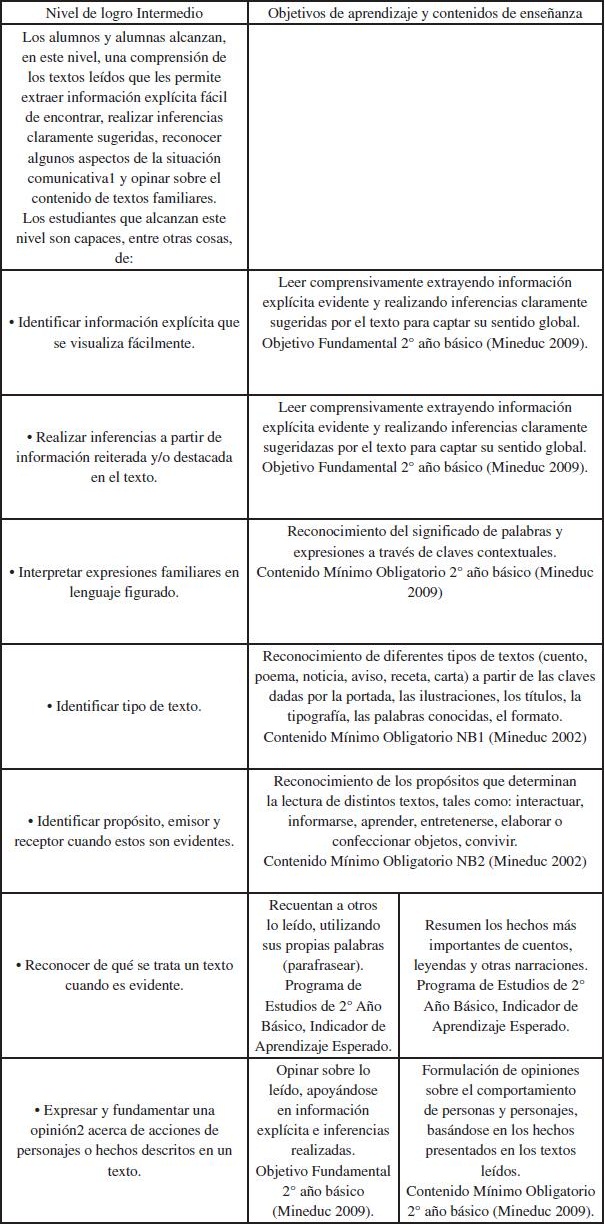

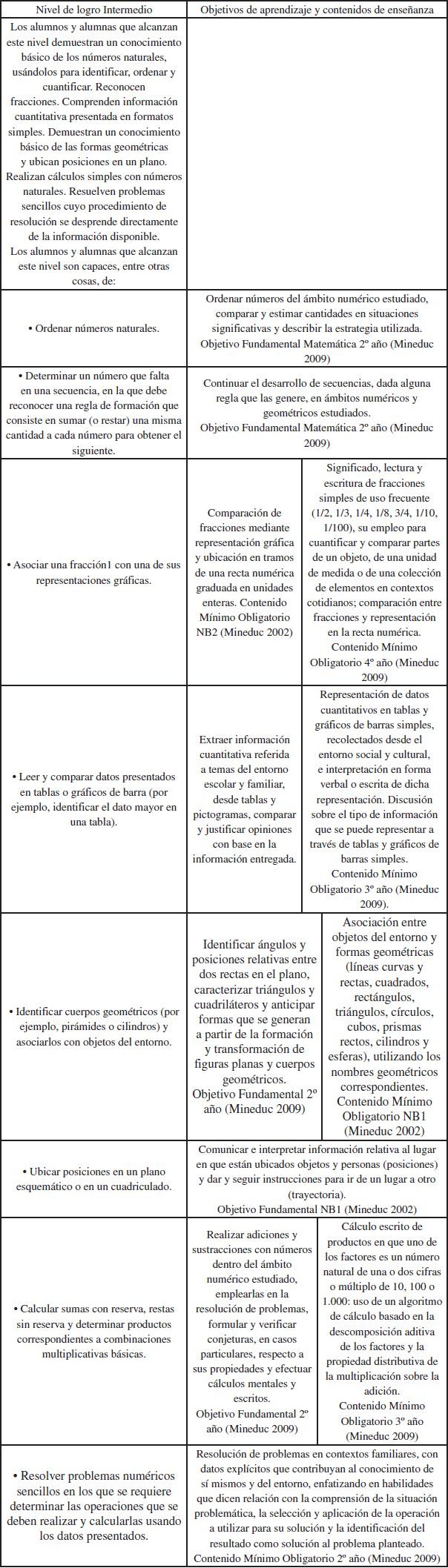

Más allá de la opinión de los encuestados, la información sobre niveles de logro requiere un alineamiento más claro con otros documentos curriculares, incluidos los mapas de progreso, para precisar su interpretación. Se supone que el nivel de logro avanzado demuestra dominio de los aprendizajes esperados para el final del grado escolar evaluado. Pero, ¿qué significa alcanzar un nivel de logro intermedio, en términos de los Objetivos Fundamentales alcanzados, del grado escolar y del nivel del mapa de progreso? Téngase en cuenta que las pruebas de 4º y 8º básico miden los OF y CMO de todo el primer y segundo ciclo de educación básica, respectivamente (Mineduc, 2010).7 ¿Significa entonces que el nivel intermedio en la prueba de 4º básico corresponde al nivel 1 del mapa de progreso, o al nivel 3 en la prueba de 8º básico?

El análisis del contenido del nivel de logro intermedio en Lectura y Matemática nos inclina a una respuesta afirmativa, puesto que la mayoría de los indicadores de este nivel de logro corresponden a aprendizajes de 2º básico en el caso de la prueba de 4º básico, tanto en Lectura como en Matemática (ver cuadros X e Y). En la prueba de Lectura de 8º básico, el nivel de logro intermedio corresponde a aprendizajes de 6º básico o menos, toda vez que la complejidad de los textos presentados a los alumnos abarca todo el segundo ciclo básico. En la prueba de Matemática de 8º básico, la mayoría de los indicadores del nivel de logro intermedio cubren aprendizajes de 5º, 6º y 7º año.

|

Cuadro 6. Alineamiento

del nivel de logro intermedio de Lectura 4º básico con objetivos

y contenidos curriculares oficiales del Ministerio de Educación |

|

Cuadro 7. Alineamiento

del nivel de logro intermedio de Matemática 4º básico

con objetivos y contenidos curriculares oficiales del Ministerio de Educación |

Se podría objetar que el análisis mostrado no tiene en cuenta la complejidad de los textos leídos en el caso de la prueba de Lectura, ni el ámbito numérico de los cálculos en la prueba de Matemática. Si estos fueran los que corresponden al 4º o al 8º básico, el nivel de logro intermedio significaría un desempeño menor aunque dentro de la complejidad de estos niveles; algo así como un 4º u 8º año no completamente logrado Pero no es así. Las preguntas de las pruebas SIMCE que han sido publicadas dejan ver que la complejidad de los textos presentados y el ámbito numérico de los cálculos es variable, abarcando todo el ciclo. Los ejemplos de ítems propios del nivel de logro intermedio tienen como referente, en general, textos y ámbitos numéricos más bien sencillos.

En principio, es positivo que las pruebas de 4º y 8º evalúen aprendizajes del ciclo respectivo y no se limiten a aquellos propios del nivel. Deberían incluso incluir aprendizajes de niveles superiores. De este modo, los resultados pueden alcanzar más valor informativo, precisando en qué nivel de un continuo de progreso en el aprendizaje se encuentran los alumnos, como lo hacen los sistemas de evaluación de países como Inglaterra y Australia (Forster, 2003; Rowe, 2007). Pero, para ello, se requiere que los instrumentos aplicados a los alumnos tengan efectivamente la capacidad de hacerlo, incorporando un número suficiente de ítems en torno o dos o tres niveles de los mapas de progreso, para hacer esta clase de inferencias (Wolfe, 2000). Los documentos técnicos que publica el SIMCE no informan nada acerca de cómo se construyen los instrumentos, con qué grado de sensibilidad se miden los objetivos fundamentales de todo el ciclo, cuántas formas se aplican, si usan o no bloques rotados de ítems.

Una consecuencia interesante de la existencia de niveles de logro, es que permite resignificar la jerarquía de puntajes brutos, en la medida en que los primeros comunican que lo importante es saber cuántos estudiantes alcanzan los diferentes niveles de logro y cuántos pasan de un nivel inferior a otro superior a través del tiempo. Esto no es lo mismo que meramente subir el puntaje promedio. Puede darse el caso de un aumento estadísticamente significativo del puntaje promedio sin que se alteren las proporciones de alumnos en los niveles de logro. Estos nos informan acerca de cuánta diferencia en los puntajes promedio significa una diferencia relevante en términos de aprendizaje, mientras que la base normativa de la prueba SIMCE y los usos jerarquizadores de los puntajes brutos, hacen creer a los usuarios que cualquier diferencia estadísticamente significativa de ellos significa algo relevante en términos de aprendizaje.

Baker (2009) sostiene que de todos los criterios de validez respecto de los usos de un instrumento de medición educacional, el principal debería ser su sensibilidad instruc-cional.8 Es decir, hasta qué punto la prueba tiene una afinidad tal con la enseñanza, que la varianza de sus resultados no solo refleja la varianza en la calidad de la enseñanza, sino que además tales resultados permiten orientar la misma de manera específica. Un sistema de evaluación externa sensible a la enseñanza hace posible, a partir de la calidad de la retroalimentación que entrega, intervenir pedagógicamente en las deficiencias y, subsecuentemente, mejorar los resultados. Así como los resultados de los exámenes de sangre del paciente permiten tomar decisiones clínicas precisas al especialista y monitorear su efecto terapéutico en el examen siguiente.

Si bien el valor de la retroalimentación depende, en cierta medida, de cómo ésta es interpretada por los docentes,9 la riqueza informativa intrínseca de los datos reportados es fundamental. Hasta antes de los niveles de logro, podríamos decir que la validez del SIMCE era al menos discutible, si no francamente cuestionable. Por una parte, este sistema ha tenido serios problemas para demostrar que la varianza de sus resultados refleja la varianza de la calidad de la enseñanza; por el contrario, ha puesto en evidencia que esta varianza depende principalmente del capital cultural y económico de los estudiantes. Por otra, no ha sido capaz de mostrar que la retroalimentación que entrega a los establecimientos ha sido aprovechada por los docentes para mejorar sus prácticas y los aprendizajes de los estudiantes.

5. CONCLUSIONES

El surgimiento y mantención del SIMCE se inscribe dentro de un proceso mayor de cambios en los modos de regulación de los sistemas educativos a nivel mundial en las últimas décadas, desde un modo burocrático-profesional, controlado por el Estado y el cuerpo docente, a uno post-burocrático, más basado en las decisiones de los consumidores del servicio educativo y en la evaluación de los resultados del sistema (Maroy, 2005).

Por la variedad de los usos de la información que entrega, por las diversas aristas técnicas del proceso de producción y procesamiento de esa información, el SIMCE es un instrumento complejo, resistente a juicios rápidos y taxativos. Sus propósitos y usos no se limitan a entregar información para que las autoridades educacionales centrales y regionales planifiquen sus políticas, como es el caso en muchos países. Para lo anterior bastaría un sistema de medición muestral. El SIMCE se propone, además, orientar a los padres en la elección de colegios y movilizar acciones remediales de los agentes educativos en todos los establecimientos, lo que explica su carácter censal. Son precisamente estos dos usos los que amenazan la validez del sistema.

Los resultados académicos de los establecimientos han orientado efectivamente a muchos padres en la elección de uno para sus hijo(a)s, pero principalmente a aquellos que pueden pagar por un servicio educativo mejor. Para el numeroso contingente de padres que no puede hacerlo, el puntaje SIMCE de los colegios tiene poco sentido, ¿cómo podría asegurarse entonces la legitimidad de este uso? Por otra parte, la información entregada por el sistema ha contribuido a crear una imagen de marca asociada a las tres dependencias administrativas, en perjuicio de la educación municipal, lo que ha ocasionado la disminución constante de su matrícula. Puede decirse que éste no era un impacto esperado de la información de logros educativos, pero es difícil no considerar este impacto como un daño, dada la centralidad de la educación pública para un país.

En su larga trayectoria de veinticinco años, la información entregada por el sistema ha servido a los tomadores de decisiones, a los investigadores, a padres y apoderados, pero no a los profesores. Ha existido un severo desbalance en el aprovechamiento del sistema por los actores mencionados, desbalance que tiene una oportunidad de mejorar gracias a los niveles de logro, en cuanto estos son un formato con mayor poder informativo para la pedagogía. Pero este aprovechamiento está aún por verse. De no corregirse el desbalance, será difícil sostener la legitimidad del uso pedagógico.

Finalmente, es justo mencionar que la validez del SIMCE depende también del sistema global de regulación de la educación del cual forma parte. Para que las mediciones del rendimiento sirvan para fundar el juicio sobre la eficacia educativa de las escuelas, tiene que existir una relación defendible entre los puntajes de la prueba y la calidad de las experiencias educativas ofrecidas en la escuela (Baker, 2009). Si el SIMCE no ha podido defender esa relación, es debido en gran parte a que las políticas educativas nacionales han permitido una fuerte segmentación social del sistema escolar, de tal modo que los puntajes terminan por reflejar la calidad del capital cultural de los estudiantes más que la calidad de las experiencias educativas.

NOTAS

1 Eyzaguirre y Fontaine (1999) levantaron una fuerte crítica respecto a la relevancia de los aprendizajes medidos en las pruebas SIMCE. Por esa fecha, el Ministerio de Educación impulsó modificaciones en las pruebas del SIMCE para alinearlas con las exigencias de la reforma curricular recién implementada.

2 Esta definición quedó establecida y documentada en los Standards for Psychological and Educational Measurement, suscritos conjuntamente por la Asociación Americana de Investigación Educacional, la Asociación Psicológica Americana y el Consejo Nacional de Medición Educativa de los EEUU en 1999 (Valverde, 2000).

3 Prueba de Chi cuadrado significativa a p=0.000.

4 Si bien se trata sólo del 29% de los padres de establecimientos municipalizados, es un número suficiente para constituirse en una minoría activa que use la voz en las escuelas.

5 La Prueba de Escritura ha sido aplicada solo a una muestra representativa de estudiantes, pese a ello el análisis de los desempeños de los estudiantes, informado en el documento de resultados, puede ser utilizado por los docentes para evaluar los escritos de sus propios alumnos con relativa facilidad.

6 Incluye solo a los docentes de básica, por ser los concernidos con la pregunta.

7 Es lo que señalan los folletos de Orientaciones para la Medición SIMCE que cada año el Mineduc pone a disposición de los docentes, disponibles en el sitio www.simce.cl. En el caso de la prueba de 2º medio, se miden los OF y CMO de 1º y 2º medio con énfasis en 2º medio.

8 La validez instruccional es un tema importante en el debate sobre evaluación y rendición de cuentas en USA (Baker, 2009).

9 La Comisión antes aludida piensa que existe un déficit de formación que dificulta que los docentes comprendan y utilicen los resultados de la medición (Ibíd., 11).

REFERENCIAS BIBLIOGRÁFICAS

Bajoit, G. (1988). "Exit, voice, loyalty ...and apathy. Les réactions individuelles au mécontentement". Revue Francaise de Sociologie, vol. 29, n. 2, 325-345.

Baker, E. (2009). "Consideraciones de validez prioritaria para la evaluación formativa y de rendición de cuentas". Revista de Educación, n. 348, 91-109.

CIDE. (2008). VII encuesta a actores de la educación. En www.cide.cl.

Comisión para el Desarrollo y Uso del SIMCE. (2003). Evaluación de Aprendizajes para una Educación de Calidad. Santiago: Ministerio de Educación.

Corvalán, J. Román, M. (2010). Permanencia de escuelas de bajo rendimiento en Chile. Informe de avance de investigación. Inédito. Santiago: CEPPE.

Eyzaguirre, B. y Fontaine, L. (1999). "¿Qué mide realmente el SIMCE?". Estudios Públicos, n. 75, 107-161.

Forster, M. (2003). Assessment Systems: two cases studies. Australian Council for Educational Research. Informe de la Comisión para el Desarrollo y Uso del SIMCE. Santiago: MINEDUC.

Himmel, E. (1997). "Impacto social de los sistemas de evaluación del rendimiento escolar: el caso de Chile". En Álvarez, B. y Ruiz-Casares, M. (Ed.), Evaluación y Reforma Educativa: Opciones de Política. Santiago: PREAL.

Hirschman, A. (1984). De la economía a la política y más allá. México: Fondo de Cultura Económica.

Kellaghan, T. (1997). "Seguimiento de los resultados educativos nacionales". En Álvarez, B. y Ruiz-Casares, M. (editores), Evaluación y Reforma Educativa: Opciones de Política. PREAL, Santiago.

Maroy, Ch. (2005). "Vers una régulation post-bureaucratique des systèmes d'enseignement en Europe?" Les Cahiers de Recherche en Education et Formation, n. 49, 1-30.

Ministerio de Educación (2002). Objetivos Fundamentales y Contenidos Mínimos Obligatorios de la Educación Básica, actualización 2002. Santiago: MINEDUC.

Ministerio de Educación (2003). Programa de Estudio 2º año Básico. Santiago: MINEDUC.

Ministerio de Educación (2009). Objetivos Fundamentales y Contenidos Mínimos Obligatorios de la Educación Básica y Media, actualización 2009. Santiago: MINEDUC.

Ministerio de Educación (2009). Niveles de Logro 4º básico Lectura, SIMCE. Santiago: MINEDUC.

Ministerio de Educación (2009). Niveles de Logro 4º básico para Educación Matemática, SIMCE. Santiago: MINEDUC.

Ministerio de Educación (2010): Orientaciones para la Medición SIMCE 4º básico 2010. Santiago: MINEDUC.

Ministerio de Educación (2010). Orientaciones para la Medición SIMCE 2º año medio 2010, Santiago: MINEDUC.

Rowe, K. (2007). Assess and Assist: Capacity building for all teachers of students, with and without learning difficulties. Australian Council for Educational Research. Background paper presented al the Combined LDA, RSTAQ and SPELD Associations Conference, Brisbane, September 2007.

Thieme, C. y Rojas, X. (2009). Aspectos conceptuales y evidencia empírica para el diseño de un sistema benchmarking de apoyo a la selección de establecimientos educativos para sectores urbanos de Chile. En MINEDUC, Evidencias para Políticas Públicas en Educación, selección de investigaciones del segundo concurso FONIDE-MINEDUC. Santiago: MINEDUC.

Valverde, G. (2000). "La interpretación justificada y el uso apropiado de los resultados de las mediciones de logro". En Ravela, P. (editor), Los próximos pasos, ¿hacia dónde y cómo avanzar en la evaluación de aprendizajes en América Latina? PREAL-GRADE.

Valverde, G. (2003). La política en evaluación y currículo ante el desafío de la calidad: lecciones de Países Bajos y Estados Unidos. Documento anexo al Informe de la Comisión para el Desarrollo y Uso del SIMCE.

Wolffe, R. (2000). "El dilema de la granularidad en el diseño del sistema de evaluación: cobertura curricular vs cobertura poblacional". En Ravela, P. (editor), Los próximos pasos, ¿hacia dónde y cómo avanzar en la evaluación de aprendizajes en América Latina? PREAL-GRADE.